Trong quá tình tạo lập và tự thits kế cho mình một trang riêng thì chắc hẳn bạn không còn quá xa lạ với File robot phải không nào. Đây là một dạng file đơn giản có thể tạo ra bởi công cụ Notepad. Vậy File Robot là gì và bằng cách nào mà chúng ta có thể tạo ra file robots txt trên Blogspot cũng như những đặc điểm của nó. Hãy cùng chúng tôi tìm hiểu về tất cả những điều này trong bài viết “Thế nào là File robots.txt và cách tạo nó cho Blogspot” dưới đây nhé.

Mục Lục

File robots.txt là gì?

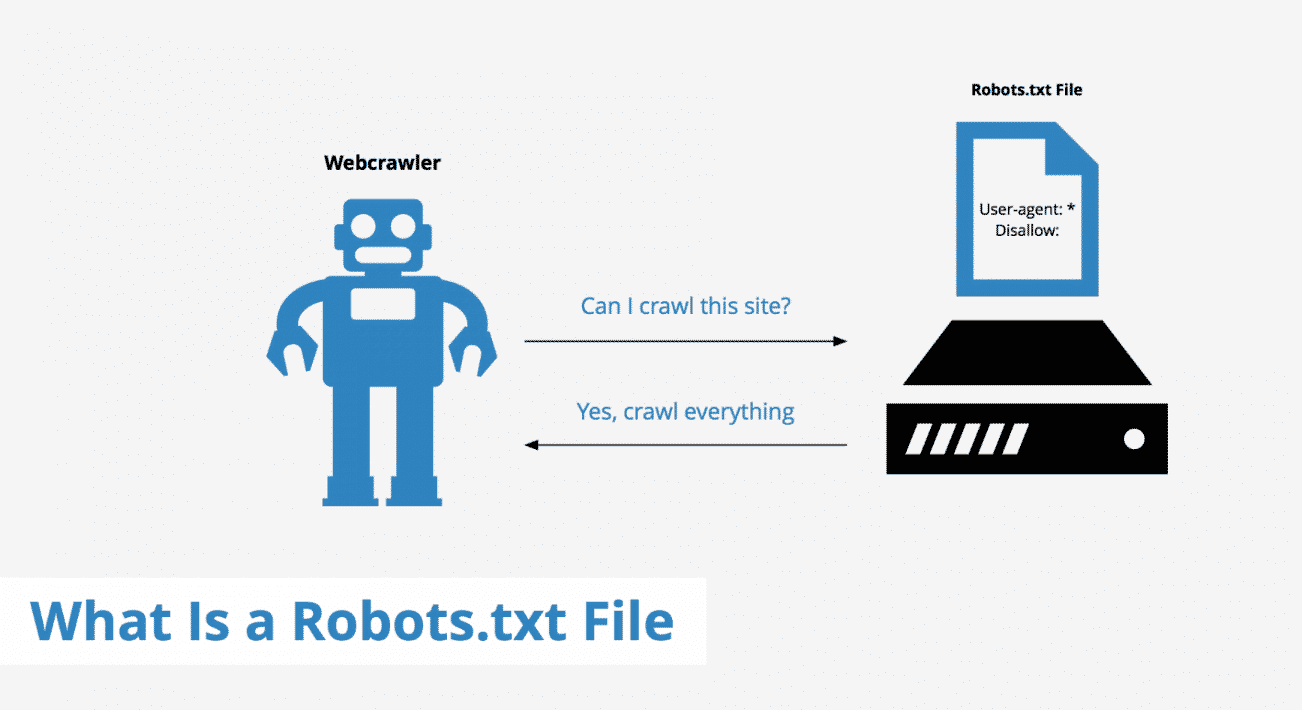

File robots.txt là một tập tin văn bản đơn giản có dạng .txt. Tệp này là một phần của Robots Exclusion Protocol (REP) chứa một nhóm các tiêu chuẩn Web. Quy định cách Robot Web (hoặc Robot của các công cụ tìm kiếm) thu thập dữ liệu trên web, truy cập, index nội dung và cung cấp nội dung đó cho người dùng.

Cú pháp của file robots.txt

Các cú pháp được xem là ngôn ngữ riêng của các tập tin robots.txt. Có 5 thuật ngữ phổ biến mà bạn sẽ bắt gặp trong một file robots.txt. Chúng bao gồm:

- User-agent: cho phép con bọ của các công cụ tìm kiếm có thể vào blogspot của mình. Nếu bạn cho phép tất cả thì nên để dấu *

- Allow: / cho phép các công cụ tìm kiếm index toàn bộ nội dung của trang

- Disallow: /search báo với bộ máy tìm kiếm là không nên tò mò về nội dung của trang này và không được index chúng.

- Crawl -delay: Thông báo cho các Web Crawler biết rằng nó phải đợi bao nhiêu giây trước khi tải và thu thập nội dung của trang. Tuy nhiên, lưu ý rằng bọ tìm kiếm Googlebot không thừa nhận lệnh này. Bạn cài đặt tốc độ thu thập dữ liệu trong Google Search Console.

- Sitemap: Được sử dụng để cung cấp các vị trí của bất kì Sitemap XML nào được liên kết với URL này. Lưu ý lệnh này chỉ được hỗ trợ bởi công cụ Google, Ask, Bing và Yahoo.

Tuy nhiên, bạn vẫn có thể lược bỏ các phần Crawl-delay và Sitemap. Đây là định dạng cơ bản của robots.txt WordPress hoàn chỉnh. Tuy nhiên trên thực tế thì file robots.txt chứa nhiều dòng User-agent và nhiều chỉ thị của người dùng hơn. Chẳng hạn như các dòng lệnh: Disallow, Allow, Crawl-delay, … Trong file robots.txt, bạn chỉ định cho nhiều con bot khác nhau. Mỗi lệnh thường được viết riêng biệt cách nhau bởi 1 dòng.

Tại sao bạn cần tạo file robots.txt?

Việc tạo robots.txt cho website giúp bạn kiểm soát việc truy cập của các con Bots. Đến các khu vực nhất định trên trang web. Và điều này có thể vô cùng nguy hiểm. Nếu bạn vô tình sai một vài thao tác khiến Googlebot không thể index website của bạn. Tuy nhiên, việc tạo file robots.txt vẫn thật sự hữu ích bởi nhiều lí do:

- Ngăn chặn nội dung trùng lặp (Duplicate Content) xuất hiện trong website. (Lưu ý rằng các Robot Meta thường là lựa chọn tốt hơn cho việc này)

- Giữ một số phần của trang ở chế độ riêng tư

- Giữ các trang kết quả tìm kiếm nội bộ không hiển thị trên SERP

- Chỉ định vị trí của Sitemap

- Ngăn các công cụ của Google Index một số tệp nhất định trên trang web của bạn (hình ảnh, PDF, …)

- Dùng lệnh Crawl-delay để cài đặt thời gian. Điều này sẽ ngăn việc máy chủ của bạn bị quá tải khi các trình thu thập dữ liệu tải nhiều nội dung cùng một lúc.

Với những đoạn mã trên khi bạn tạo xong thì hãy chèn chúng vào trong hộp thoại Robots tùy chỉnh và lưu lại. Như vậy là đã hoàn thành một file robots.txt hoàn chỉnh cho Blogspot. Nếu như đọc đến đây và các bạn thắc mắc rằng sitemap trong bài viết đó là gì. Thì xin thưa rằng đó là nội dung tiếp theo mà mình sẽ hướng dẫn cho các bạn trong tuần sau. Còn bây giờ mình xin kết thúc bài hướng dẫn tạo file robots txt. Nếu các bạn thấy hữu ích thì hãy share cho mọi người cùng biết